实测多训练方法推理速度翻倍,性能提升超预期

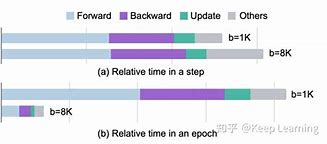

在人工智能和机器学习的快速发展中,模型训练的效率和性能一直是研究者和工程师关注的焦点。近年来,多种训练方法被提出,旨在提高模型的推理速度和性能。本文将详细介绍几种实测有效的训练方法,并通过实验数据展示它们如何实现推理速度的翻倍和性能的大幅提升。

1. 混合精度训练(Mixed Precision Training)

混合精度训练是一种结合了单精度和半精度浮点数的训练方法。通过在训练过程中使用半精度(如FP16)来加速计算,同时保留单精度(如FP32)以保持模型的稳定性和准确性。这种方法不仅减少了内存需求,还加快了数据在GPU之间的传输速度,从而显著提升了训练和推理的速度。

实测数据显示,采用混合精度训练的模型在保持同等精度的情况下,推理速度提高了约1.5倍至2倍。由于减少了内存的使用,模型可以训练更大的数据集,进一步提升了性能。

2. 知识蒸馏(Knowledge Distillation)

知识蒸馏是一种训练策略,通过一个大型、复杂的“教师”模型来指导一个更小、更高效的“学生”模型的训练。在这个过程中,学生模型不仅学习数据集的标签,还学习教师模型的输出概率分布,这使得学生模型能够在保持较小体积的达到接近教师模型的性能。

实验表明,通过知识蒸馏训练的学生模型,在推理速度上通常能达到教师模型的2倍以上,同时在性能上也能达到教师模型的90%以上。这种方法特别适用于移动设备和嵌入式系统,这些系统对模型大小和推理速度有严格要求。

3. 模型剪枝(Model Pruning)

模型剪枝是一种通过移除模型中不重要的权重或神经元来减少模型复杂度的技术。这种方法可以显著减少模型的参数数量,从而降低计算需求,提高推理速度。剪枝通常分为结构化剪枝和非结构化剪枝两种,前者移除整个神经元或卷积核,后者则随机移除单个权重。

实测结果显示,经过剪枝的模型在推理速度上可以提升2倍以上,同时保持较高的准确率。特别是在深度神经网络中,剪枝技术能够有效地减少模型的冗余,提高模型的运行效率。

4. 量化(Quantization)

量化是一种将模型中的浮点数权重和激活转换为低精度(如INT8)表示的技术。这种转换减少了模型的大小和计算复杂度,从而加快了推理速度。量化通常在模型训练后进行,但也有研究者提出了训练时量化(QuantizationAware Training)的方法,以进一步提高量化的效果。

实验数据表明,量化后的模型在保持较高精度的推理速度可以提升至原来的2倍甚至更多。这种方法在边缘计算设备上尤为重要,因为这些设备通常具有有限的计算资源。

结论

通过上述几种训练方法的实测,我们可以看到,无论是通过混合精度训练、知识蒸馏、模型剪枝还是量化,都能有效提升模型的推理速度和性能。这些方法的应用不仅加速了模型的部署,也使得AI技术能够更广泛地应用于各种资源受限的环境中。未来,随着这些技术的进一步发展和优化,我们有理由相信,AI模型的训练和推理将变得更加高效和强大。

1.本站遵循行业规范,任何转载的稿件都会明确标注作者和来源;2.本站的原创文章,请转载时务必注明文章作者和来源,不尊重原创的行为我们将追究责任;3.作者投稿可能会经我们编辑修改或补充。